# 平台简介

# 什么是AIUI

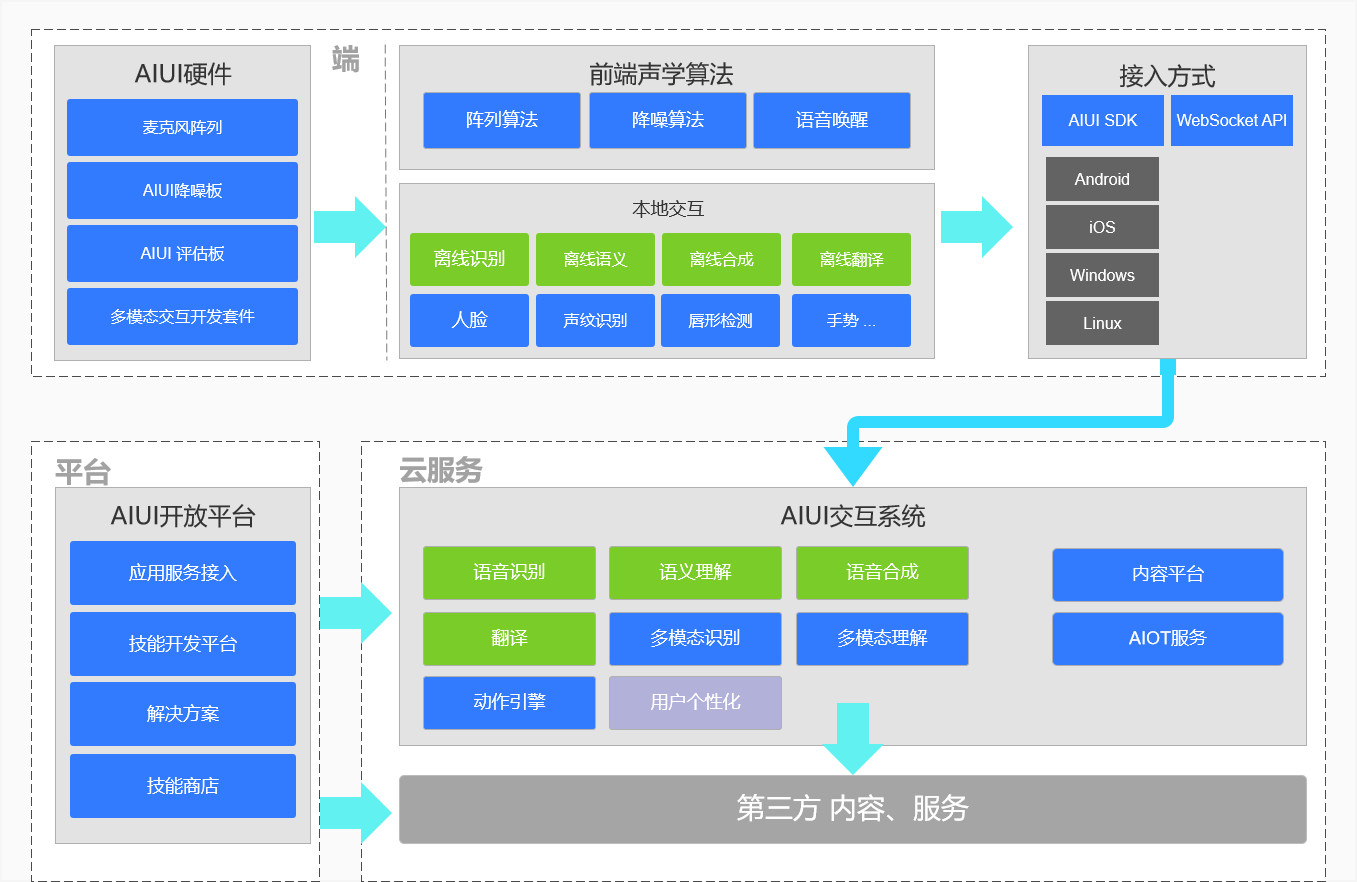

AIUI 是科大讯飞提供的一套人机智能交互解决方案, 旨在实现人机交互无障碍,使人与机器之间可以通过语音、图像、手势等自然交互方式,进行持续,双向,自然地沟通。

现阶段 AIUI 提供以语音交互为核心的交互解决方案,全链路聚合了语音唤醒、语音识别、语义理解、内容(信源)平台、语音合成等模块。可以应用于智能手机、机器人、音箱、车载、智能家居、智能客服等多种领域,让产品不仅能听会说,而且能理解会思考。

AIUI 开放平台 (opens new window)主要包含了应用配置(设备接入AIUI)、解决方案(查看AIUI软硬件产品和方案)、技能工作室(开发语义技能和问答)、技能商店(查看AIUI技能和内容)等功能,并为不同形态产品提供了不同的接入方式。目前有如下接入方式:Android、iOS、Windows、Linux多个平台的SDK,如果需要云端接入, AIUI也提供基于 WebSocket 协议的 WebSocket API 接入方式;

科大讯飞在语音领域深耕多年,拥有声学处理、语音识别、语音合成、语音评测等核心技术。AIUI 从 2015 年发布至今,基于核心技术不断打磨效果,逐步成熟,是一套功能完善、易于接入的人机交互解决方案。

# AIUI应用领域

AIUI作为人机交互解决方案的引领者,致力于将自然语言理解及交互能力向合作伙伴开放,降低开发者集成门槛。通过提供垂直领域一站式人机交互解决方案,加速与各行业深度融合和落地应用,实现用人工智能建设美好世界的愿景。

# 机器人

让机器人能听会说,能理解会思考。轻松满足语音控制,业务咨询、情感交流等机器人核心应用场景。

# 电视/投影仪

AI升级,新体验。让用户彻底告别遥控器,动动嘴巴就可以实现影视点播、页面跳转、播放控制。

# KTV语音点歌

引领KTV人机交互创新,无需唤醒,拿起麦克风即可完成语音点歌、点歌机控制、服务呼叫。

# 大屏语音调度

围绕企业展厅,指挥调度中心大屏语音交互需求,提供手持演示器和麦克风阵列,轻松实现业务查询,大屏页面切换,设备控制。

# 语音助手

融合低功耗唤醒,声纹识别等关键技术,与产品功能和业务流程深度耦合,让用户告别双手,一句话搞定复杂操作。

# 智能客服

基于知识图谱,智能问答系统为企业定制知识库,多渠道接入,24h实时在线,显著提升客服效率,降低客服人力成本。

# 智能音箱

一站式解决方案,提供前端声学设计专业指导,海量内容及官方内容一键接入,针对有屏无屏,儿童成人等场景,自动切换回复风格及推送内容。

# 车载

AI助力智能座舱,围绕行车便利、安全、愉悦三大核心诉求,提供车辆控制、驾驶行为监控、语音点播等多项能力。

# 智能家居

以语音交互为入口,对接主流AIOT平台,全品类覆盖,轻松实现家居智能控制。

# AIUI开放平台功能

AIUI,将讯飞强大的单点交互能力(前端声学处理,图像手势识别、语音识别、语义理解,语音合成,丰富的内容信源)编排为全链路的交互方案提供给广大开发者,开发者可以根据实际的业务需求,利用AIUI平台进行个性化的识别、语义和合成的配置优化和改进,提升交互准确率,让人机交互更加流畅,真正的满足和解决用户实际使用中所遇到的问题。

平台主要功能有:

# 应用接入

应用接入是你的设备接入AIUI交互的入口,创建应用进入到应用信息里,这里功能主要有:

- 应用信息:获得应用接入的APPID和密钥(key);

- 开发资料:SDK和接口文档全在这里下载;

- 定制唤醒词:定制你的专属唤醒词,打包下载唤醒;

- 识别引擎:配置多语种或方言,设置使用远场或近场和选用不同领域的识别引擎,优化识别效果;

- 敏感词过滤:配置开启识别或语义敏感词过滤,让敏感信息不展示给用户;

- 语义理解:配置你开发的或者AIUI官方提供的语音技能;

- 合成发音人:选择你喜欢的合成发音人,设置语速等。

# 解决方案

这里可以查看和了解AIUI的技术方案、行业产品方案以及AIUI的软硬件开发套件信息,联系AIUI提供咨询和方案接入支持;

# 技能工作室

- 自定义技能:开发业务相关的语音交互技能;

- 自定义问答:开发语音交互的问答,可以支持整句模糊匹配和关键词匹配;

- 设备人设:AIUI已经植入了所有和设备人设相关问题,你只需要填写答案关键信息就可以完成人设技能。

# 技能商店

查看和体验讯飞官方提供的语音技能。

# AIUI硬件模组

AIUI提供了从麦克风阵列声卡(解决录音问题)、降噪板(可输出纯净音频)到成品硬件等完整的硬件接入和开发套件,帮助开发者更快速的接入AIUI和验证项目。

- USB声卡

用于设备录音及喇叭回声采集,适配多种麦克风阵列构型,了解详情 (opens new window)。

- 3308语音降噪板

内置讯飞降噪算法及离线命令,支持3.5mm音频口输出纯净音频,适用录音、降噪,离线交互多种需求, 了解详情 (opens new window)。

- R818语音降噪板

内置讯飞降噪算法及离线命令,USB口输出降噪音频,适用录音、降噪,离线交互多种需求, 了解详情 (opens new window)。

- AIUI评估板

搭载AIUI全链路语音交互能力,接口类型丰富,方便客户快速了解AIUI平台各项能力,完成方案验证, 了解详情 (opens new window)。

- RK3399多模态交互板

集成讯飞语音、手势、人脸等多项AI能力,高配置,小体机,适用于大屏一体机,机器人等公共场所人机交互场景, 了解详情 (opens new window)。

# AIUI本地端能力

# 前端声学

前端声学位于语音唤醒之前,用于解决语音交互领域的几大典型问题,包括混响,背景噪声,人声干扰、回声。通过提升信噪比,确保设备唤醒率和语音识别率满足正常交互要求。

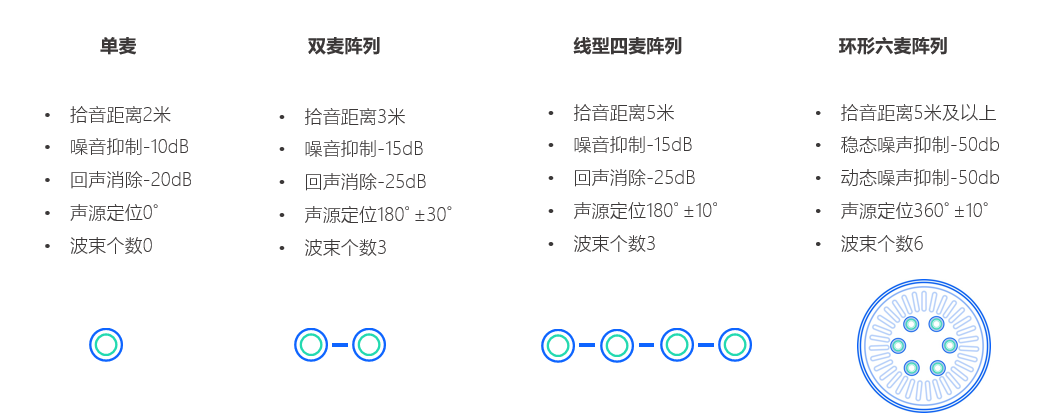

- 麦克风阵列

麦克风按照一定的空间几何位置排列,构成麦克风阵列。讯飞提供的麦克风阵列构型如下:

客户如需自行设计麦克风阵列可以联系AIUI获取阵列设计参考

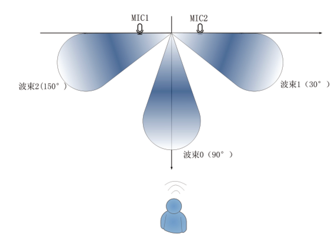

- 波束形成

基于麦克风阵列在不同位置对声音信号进行采集,经过空域滤波算法使其在预定方向具有拾音指向性。线性2麦阵列波束形成如下图所示:

- 回声消除

喇叭播报音频通过空间反射会重新进入到麦克风,叠加原始交互音频后,影响设备唤醒率和语音识别准确率。通过回声消除算法,可将喇叭回采音频显著抑制,从而实现播报打断,全双工交互。

- 去除混响技术

声波在室内传播时,被墙壁、天花板、地板等障碍物反射形成反射声,并和直达声形成叠加,构成混响。基于去混响算法,能够有效消减声音中的反射声,提升声音的清晰度。

- 噪音抑制

噪声抑制技术用于消除人机交互中背景噪声,提升语音信号的信噪比,从而显著提升唤醒率和语音识别准确率。该技术适用于单麦克风和麦克风阵列,对稳态噪声有较为显著的抑制效果。

- 声源定位

类似人耳的听声辩位,通过计算麦克风阵列中各麦克风获取声音信号的时延, 来确认一个声音在空间来源。该技术广泛应用于服务机器人行业、会议室系统等场景。通过确认说话人的位置,以便面向目标对象进行服务。

# 语音唤醒

语音唤醒是指通过3-6个音节的唤醒词,将设备从不对外部声音进行识别的休眠状态唤醒为接受并识别外部声音的交互状态。讯飞的语音唤醒具有小尺寸,低功耗,高唤醒的特点。并且用户可自定义唤醒词,单个设备最高支持数百个唤醒词结合离在线语音交互场景同时使用,可以做到设备达到“免唤醒”语音交互的效果。

# 本地语音识别

本地语音识别, ESR(Embedded Speech Recognition)。满足无网络环境下的语音转文字的需求,实时输入音频流,并在一定响应时间内给出识别结果。SDK轻巧方便,无需网络流量,实时响应,支持标点、数字规整和实时出字。

# 本地命令词识别

基于讯飞唤醒引擎服务实现的离线命令词识别服务,实现快速稳定的本地化语音服务,可以支持300条命令词。SDK 适配Android、Linux多终端系统,支持讯飞多麦克风阵列远距离控制,适用不同的噪声环境,做到零流量实时响应。还可以支持开发者自定义命令词,满足应用个性化需求。

# 本地文法语义

AIUI SDK 支持文法语义定制,可扩展至128个槽位、30000个词条,支持用户自由说,可以实现设备的精细控制;配合本地内容资源,还可以满足特定领域语义理解,实现纯离线语音交互,如户外拉杆箱(点歌机)或车载KTV的离线语音点歌。

注意:

本地文法语义对算力占用有要求,如2核1.4G设备,运行状态CPU占用15%,内存占用约70M。

# 本地合成

本地语音合成引擎,满足无网络环境下转语音需求,SDK 轻巧方便,无需网络流量,实时响应。支持中文、英文等多种语种的合成,支持根据业务需求选择合适的音量、语速等属性,更有多种发音人音色供选择。产品适用于离线语音合成播报、配合离线语义给与语音交互及设备操控反馈。

# 多模态VAD

除了语音VAD,AIUI还支持多模态VAD技术。即通过摄像头,将视频流中的人脸唇形实时检测识别,结合语音、能量等VAD技术多种维度判别主要说话人意图,辅助云端多模态识别引擎,保障在多人、嘈杂的复杂场景下精准识别,实现人机交互的流畅性。

# 图像人脸

人脸识别,英文FaceRecogniton,简称FR,是基于图像信息对人脸进行检测、分析、身份识别的一种生物识别技术。人脸识别引擎包含人脸检测、人脸识别、人脸跟踪、交互活体检测、静默活体检测、人脸1:1比对、人脸1:N检索等功能。开发者可以通过人脸识别、活体检测及身份核验,进行本地预警,为场景提供安全保障服务。产品适用于通道闸机、学校、社区、写字楼、酒店、商场、商店、公共服务场所等通行场景,适应强逆光、远距离和暗光等复杂环境。

# AIUI服务端能力

# 在线语音识别

语音识别(ASR)是一种将人的语音转换为文本的技术。除中文普通话和英文外,支持24种方言和1个民族语言,提供四川话、广东话与普通话的混合识别。

- 近场识别

指发言人距离拾音设备指1m内,一般为手持设备录音时的状态。适用产品如手机、电视遥控器等。

- 远场精准识别

指发言人距离拾音设备指1~5m 的距离,依托科大讯飞麦克风阵列技术和前端声学算法,结合远场识别引擎,实现5米远的距离收音并保障语音识别准确率。适用产品如有屏无屏音箱、机器人。

注意:

远场识别引擎:通过专门的深度学习训练,适配远场声波特征,可让远距离人声的识别更准确。

- 方言识别

在普通话引擎下,对于非标准的,有一定方言特点的普通话,可以实现方言口音自适配,且保证优秀的识别效果。 同时 AIUI 拥有 23 种方言引擎,开发者可以根据实际业务需求,动态切换方言引擎。

注意:

当使用方言引擎时,开发者需要根据方言表述特色编写对应的语料,以完成语义理解的能力。

- 持续录音,连续识别

AIUI 支持两种识别模式:单轮交互模式(Oneshot)和 全双工模式(Continue)。

基于 VAD 的自动断句或按下说的单轮交互模式。如手机 APP 或者语音电视遥控器等单麦克风设备,一般使用按下说的单轮交互,此时需要用户或程序主动触发录音,交互特点是一次触发一次响应。

持续开启语音监听和识别的全双工模式。在此模式下需要设备具有较好的回声消除效果。如使用麦克风阵列的硬件,智能音箱,智能耳机等产品。交互特点是一次触发后,可以根据业务需求保持交互状态10秒~120秒,实现一次触发多次响应。

两种识别模式各有优劣,产品应当根据具体的产品形态和使用场景进行设计。

注意:

语音活动检测(Voice Activity Detection,VAD)又称语音端点检测,语音边界检测。目的是从声音信号流里识别和消除长时间的静音期,以判断一句话的开始与结束。

- 拒识,过滤无效语音 在全双工的模式下,系统通过智能检测及语义拒识等模块,对上传的语音进行有效判断,可以将与业务场景无关的语音和无效的噪音进行过滤,例如嗯、啊、哦等语气词。

注意:

全双工模式下,仍然会有小概率的误触发问题存在。

# 语义理解

语义理解(NLP)指将一句自然语言转化为计算机可读的结构化数据。语义理解也是 AIUI 的核心功能。

例如“明天合肥天气怎么样”这句自然语言中,经过 AIUI 语义理解引擎,会将这句话解析成如下的 Json 数据:

{

"semantic": [

{

"intent": "QUERY",

"slots": [

{

"name": "datetime",

"normValue": "2018-01-19"

},

{

"name": "city",

"normValue": "合肥"

}

]

}

],

"service": "weather"

}

# 敏感词过滤

敏感词是指涉黄、涉暴、涉政、涉恐或者儿童不宜的词汇,AIUI支持对语音识别结果和技能回复语进行敏感词校验。开启敏感词过滤,当出现敏感信息时,敏感信息将会被过滤掉,不展示给用户。

敏感词过滤当前未默认开放,如需使用,可以联系AIUI运营开启。

# 语音合成

语音合成(TTS)是指将文字信息转化为声音信息,给产品配上“嘴巴”。讯飞提供了众多极具特色的发音人(音库)供您选择。其合成音在音色、自然度等方面的表现均接近甚至超过了人声。拥有中英粤多语种、川豫多方言、男女声多风格的选择,音量、语速、音高等参数也支持动态调整,同时提供定制专属发言人。

# 内容(信源)

内容(信源)指语义理解后对客户真实有用的数据,例如天气具体状态,音乐的播放链接。AIUI 技能商店中多数技能具有相对应的信源,在最终的结构化数据 Json 中表现为 data 字段。我们诚邀各类内容提供商与我们合作,包括但不限于音视频资源、流媒体、新闻、自媒体、儿童故事与游戏、股票违章查询等功能类资源,讯飞提供了多种合作方案,和内容提供商共享 AI 时代的流量红利。

# 语音翻译

语音翻译是指将发言人说的话翻译为其他语种,给产品获得翻译能力。开发者可以在应用的情景模式添加翻译模式,AIUI目前支持英、日、韩、法、西、俄、阿拉伯等语种的翻译。

翻译模式属于AIUI有偿开放服务,如需使用,可以联系AIUI运营开启。

# AIUI交互指导

# 按键交互

按键交互是指硬件本身有录音按钮,按下录音,松开后停止录音。适用场景如电视遥控器、语音鼠标。

或者软件界面里有虚拟按钮,按住录音,松开停止录音;也可以点一下开始录音,利用VAD停止录音。适用场景如手机、APP、手表等产品语音助手。

# 唤醒交互

设备有唤醒词,用户先喊唤醒词,设备被唤醒后才能进行语音交互。后续每次和设备交互都需要先唤醒,一次唤醒、一次交互。适用语音唤醒的交互主要智能音箱、智能家居面板等远场语音交互。

唤醒交互,用户与音响的沟通如下:

用户:小飞小飞,今天的天气怎么样

音箱:今天合肥市晴,20~26摄氏度,紫外线……

用户:(打断音箱说话)*小飞小飞*,明天呢

音箱:明天合肥多云,22~27摄氏度,紫外线指数强,较适宜运动。

每次交互需要先唤醒音箱

唤醒算力占用说明

在2核1.4G的设备上:

- 静默状态:cpu占用5%;内存占用20M;

- 运行状态:cpu占用25%;内存占用20M;

# 全双工交互

指在设备扬声器发声时,且不关闭麦克风的情况下,用户可以打断设备的播放,进行语音识别和语义理解。

全双工交互,用户与音响的沟通如下:

用户:叮咚叮咚,今天的天气怎么样

音响:今天合肥市晴,20~26摄氏度,紫外线……

用户:(打断音箱说法)明天呢

音响:明天合肥多云,22~27摄氏度,紫外线指数强,较适宜运动。

PS: 用户无需再说唤醒词,可以自然的进行对话。

# 离线语音交互

离线语音交互是将语音交互需要的服务下发至本地,通过本地解析实现原本只能在线才能支持的语音交互服务。AIUI离线语音交互服务可以对外暴露了接口,支持开发者定制更新资源,进一步的提升设备化个性语音交互体验。

AIUI离线交互的特点

1、 实现了没有网络也可以使用语音交互服务;

2、 纯离线场景可以有效的防止误触发,保障用户体验;

3、 网络不稳定时,可以自动切换离线服务,并保证响应速度;

4、 带屏设备屏幕里出现的所有内容均可以语音操作;

离线语音交互算力占用说明

在2核1.4G的设备上:

- 静默状态:cpu占用5%;内存占用70M;

- 运行状态:cpu占用15%;内存占用70M;

# 免唤醒交互

免唤醒语音交互 (opens new window)是讯飞2019年打造的自然人机语音交互技术,实现了直接说话就可以和设备语音交互,兼容各种麦克风阵列构型;该技术方案没有网络也可以使用,可以有效的防止误触发,直观提升产品的语音交互体验。

免唤醒+离线交互同时使用,算力占用说明

在2核1.4G的设备上:

- 静默状态:cpu占用10%;内存占用90M;

- 运行状态:cpu占用35%;内存占用90M;

PS:单独使用免唤醒功能,算力占用相比唤醒占用变化不大。

# 多模态交互

区别单一模态的语音交互,多模态交互在人机交互过程中,融合声纹识别,手势识别、唇形检测、虚拟人形象等AI核心技术,让人机交互方式更丰富,交互过程更自然。

当前AIUI提供了人脸检测、唇形识别、图像识别、声纹识别等多种AI能力,配合讯飞前端声学技术,辅助提升公共场景、复杂人声背景噪音下的语音识别准确率。用户可基于业务场景自由选择其中的部分或全部能力,并通过自定义技能及技能后处理实现交互流程的设计。

快速入门 →