# 概览

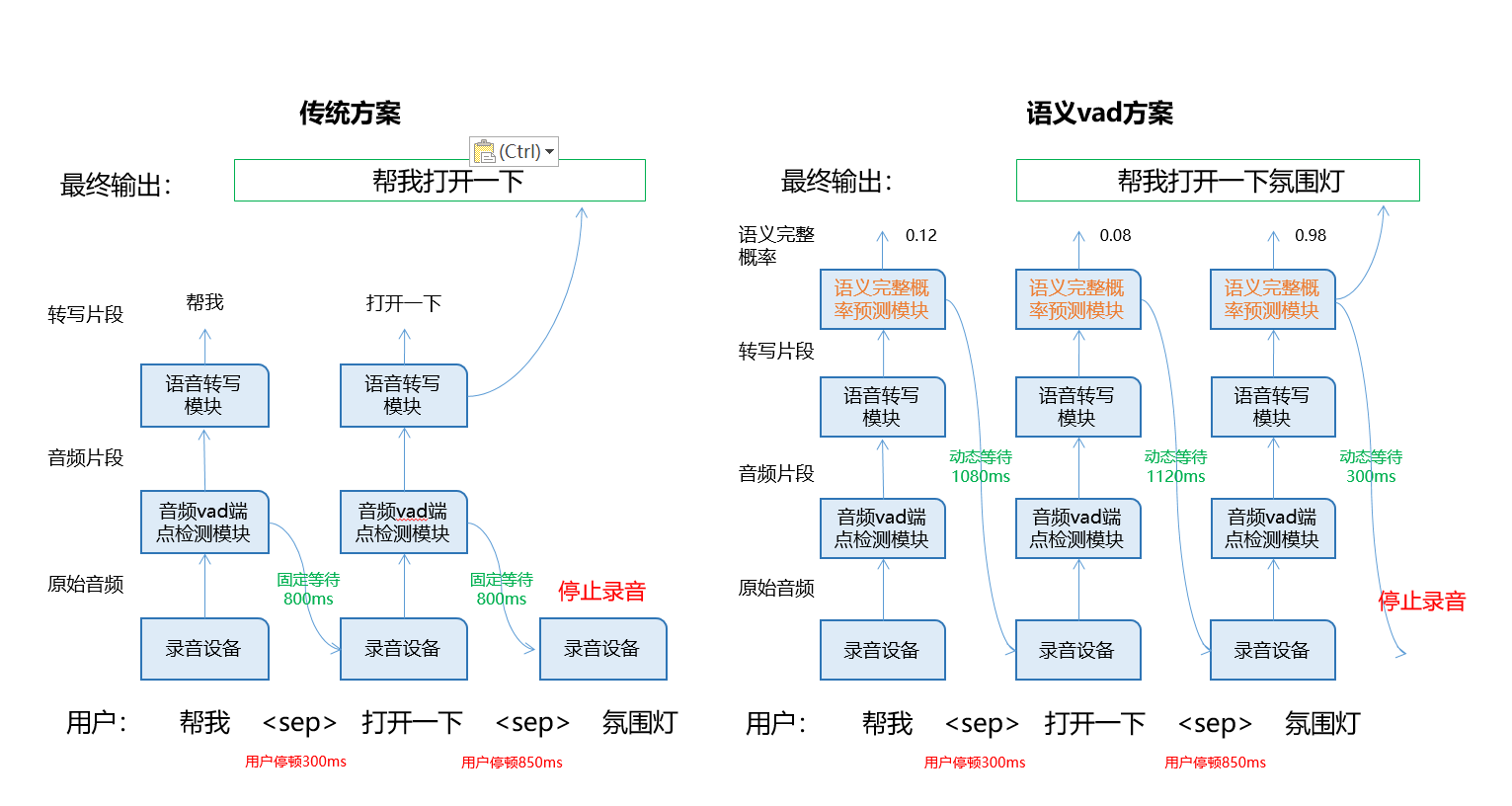

语音交互系统中很多交互失败的样例,都是因为用户表述没有结束,前端收音设备就停止了收音,导致后端语义理解模块无法获取完整准确的用户意图;

上述问题的根本原因是现有音频收录识别系统中,在用户停顿后的等待收音时间是一个固定值,无法满足多变的对话环境;

针对上述问题,AIUI平台推出语义vad技术:创新设计以用户语义完整度概率预测为目标,动态调整VAD等待时间,融合通用预训练模型,充分利用海量无标签文本数据,能够显著改善因用户停顿或者噪声导致的收音截断问题。

# 开启方法

1. 在 aiui.xfyun.cn (opens new window) 平台我的应用→应用配置→语义理解→开启语义VAD

2. 点击保存。(语义 VAD 开启需要一定的时间,接下端上的操作请等候一两分钟)。

3. 请下载5.6.1071.0000及以后版本的SDK(2022-05-27后更新版本),SDK配置为continue模式,不要使用oneshot模式。

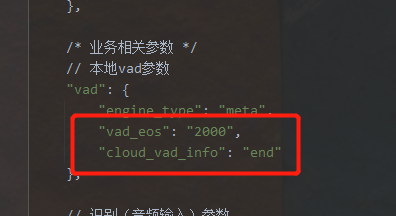

4. 在端上的 SDK 配置文件 aiui.cfg 中的 vad 配置段添加以下内容:

- vad_eos 这是本地的 VAD 后端点时长, 默认云端是 1.8s,所以本地可以设置为 2s

- cloud_vad_enable 开启云端 VAD 的配置

5. 最终如下图所示:

6. 不用做其他处理,正常交互即可。

7. 注意:目前只有通用远场识别引擎可以按照这种方式开启,如果想要在通用近场识别引擎上使用语义VAD请联系技术支持(aiui_support@iflytek.com)